禁止套娃:專家用AI生成的錯誤信息爲反AI的錯誤信息法辯護

大型語言模型在證明其可信度和可靠性之前,還有很長一段陡峭的路要走。 就目前而言,這些模型有助於開展研究,但只有傻瓜纔會相信它們足以撰寫法律文件,專業教授應該更清楚這一點。然而,斯坦福大學的一位教授向法庭提交了一份宣誓書,支持明尼蘇達州一項有爭議的法律,該法律旨在遏制使用深度僞造和人工智能影響選舉結果。

對現行法律的擬議修正案規定,在競選活動中使用深度僞造技術而被定罪的候選人必須放棄競選,並根據前科數量面臨最高五年和一萬美元的罰款和監禁。

明尼蘇達州衆議員瑪麗-弗蘭森(Mary Franson)和YouTuber克里斯托弗-科爾斯(Christopher Kohls)對該法律提出質疑,稱其違反了憲法第一修正案。 在預審過程中,明尼蘇達州總檢察長 Keith Ellison 要求斯坦福大學社交媒體實驗室的創始主任 Jeff Hancock教授提供一份宣誓書,聲明他支持該法律。

傑夫-漢考克教授通過 CourtListener發表的專家聲明全文:

https://storage.courtlistener.com/recap/gov.uscourts.mnd.220348/gov.uscourts.mnd.220348.23.0.pdf

《明尼蘇達改革者報》指出,漢考克起草了一份看似措辭嚴謹的論證,說明了立法的必要性。 他引用了多個資料來源來證明自己的觀點,其中包括《信息技術與政治期刊》(Journal of Information Technology & Politics)上一篇名爲《深度僞造視頻對政治態度和行爲的影響》(The Influence of Deepfake Videos on Political Attitudes and Behavior)的研究。 他還引用了另一篇名爲《深度僞造和幻覺: 錯誤信息接受背後的認知過程》。 問題是,這些研究都不存在於上述期刊或任何其他學術資源中。

原告提交了一份備忘錄,暗示這些引文可能是人工智能生成的。 即使這些引文並非出自法學碩士之手,但這些可疑的引文也對聲明的有效性提出了質疑,因此法官應該將其駁回。

備忘錄中寫道:"該引文具有人工智能'幻覺'的特徵,表明至少該引文是由 ChatGPT 這樣的大型語言模型生成的。原告不知道這個幻覺是如何出現在漢考克的聲明中的,但它使整個文件受到質疑。"

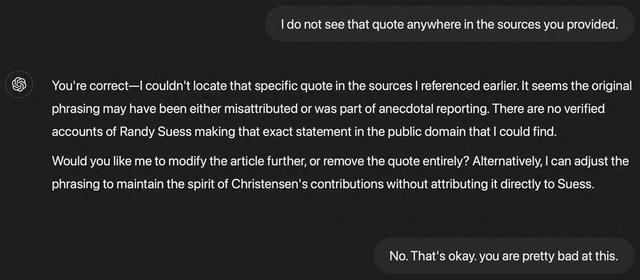

如果引文是人工智能生成的,那麼宣誓書的部分內容甚至全部內容也極有可能是人工智能生成的。 在對 ChatGPT 的實驗中,TechSpot 發現,LLM 會編造一些並不存在的引文,顯然是爲了給故事增添可信度。 當被問及此事時,聊天機器人會承認自己編造了這些材料,並會用更可疑的內容對其進行修改(上圖)。

可以想象,漢考克無疑是個大忙人,他寫了一份宣言草案,交給助手編輯,助手通過法律碩士對其進行了清理,而模型則在未經提示的情況下添加了參考資料。 然而,這並不能成爲該文件不受應有的審查和批評的藉口,而這正是當今法律碩士的主要問題所在。

一位自稱專家的人向一個法律機構提交了一份包含人工智能生成的錯誤信息的文件,以支持一項禁止此類信息的法律,這對任何相關人員來說都不失爲一種諷刺。 埃裡森和漢考克都沒有對此發表評論,他們很可能希望這個尷尬的失誤就此消失。

更誘人的問題是,法庭是否會認爲這是僞證行爲,因爲漢考克在簽名時說:"我聲明,在僞證罪的懲罰下,我在本文件中所陳述的一切都是真實和正確的"。 如果不追究濫用人工智能的責任,人工智能又怎麼會好起來呢?